X发布Grok 3

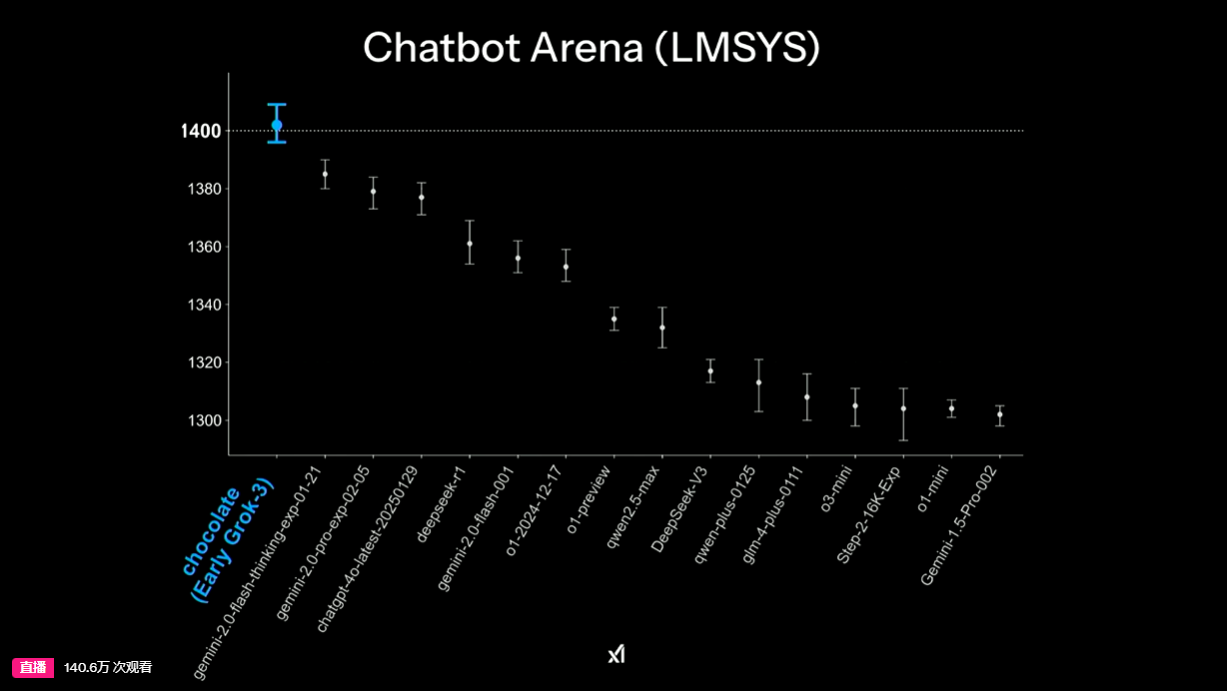

总结:Grok3相比前代计算量提升10倍,支持复杂推理功能。马斯克团队仅用122天建成10万张显卡的计算中心,工程效率惊人。Grok3在数学(AIME 96分)和编程测试(GPQA 85分)表现优异,LMSYS平台排名第一。新增Big Brain模式增强计算能力,可辅助俄罗斯方块等推理游戏,具备网页搜索功能deep research(类似Perplexity水平)。预计一周内完成功能更新,API需等待数周,多模态语音模式即将推出。Grok3推理能力接近o1-pro模型,略优于DeepSeek-R1和Gemini 2.0。目前综合能力位居排行榜首位。

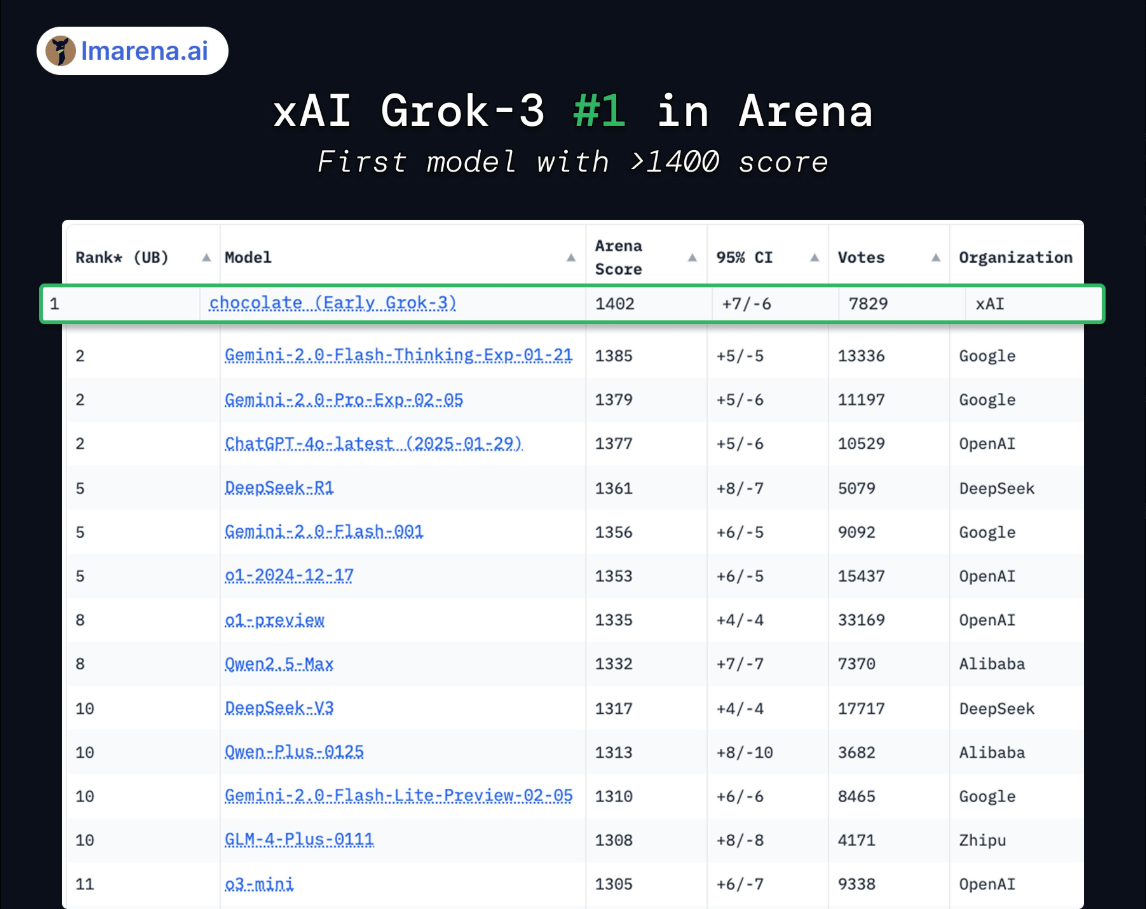

截至2025年2月18日,Grok 3在以下排行中全部是第一:

- 总体控制与风格控制

- 硬提示 & 带风格控制的硬提示

- 编程

- 数学

- 创意写作

- 指令遵循

- Longer Query(长查询)

- 多轮对话

1、老马的新计算中心,有 20 万张卡。 一期 10 万张卡只用了 122 天就建设完成

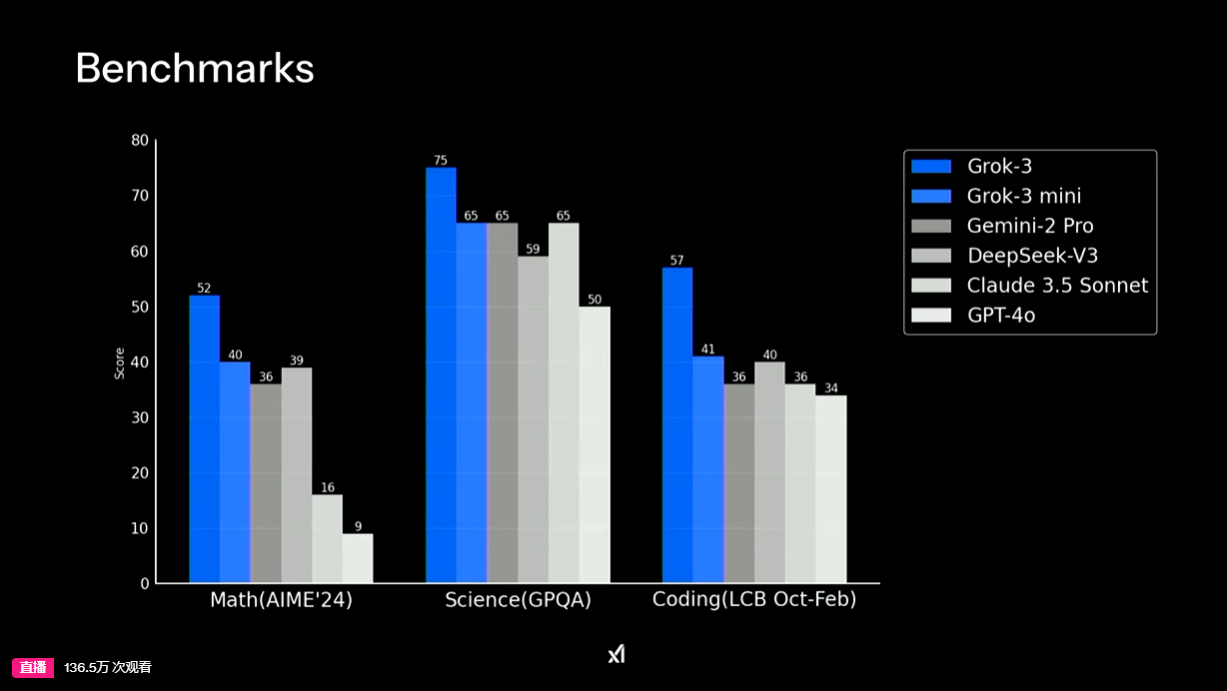

2、Arena LMSYS 1400 分(全球第一个达到这个分数的)以及数学和代码都很高

Chatbot Arena(LMSYS):大语言模型基准测试和多模型比较性能的在线竞技平台

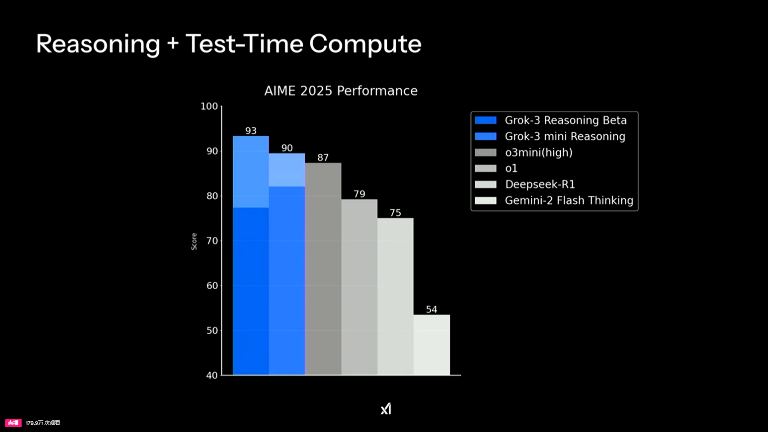

3、Grok 3 和 mini 的 AIME 得分

AIME:美国邀请赛数学考试

在 AIME 上取得了 96 分,在 GPQA 上取得了 85 分,与完整的 o3 相当

GPQA 是一个研究生级别的Google验证问答基准测试,旨在评估模型对于生物学、物理学和化学等学科领域的深入理解

LMSYS 目前排第一

Grok 3 在创意编程方面也很强 还有 Big Brain 模式,通过 Grok 3 进行更多的计算和推理。

Grok 3 在创意编程方面也很强 还有 Big Brain 模式,通过 Grok 3 进行更多的计算和推理。

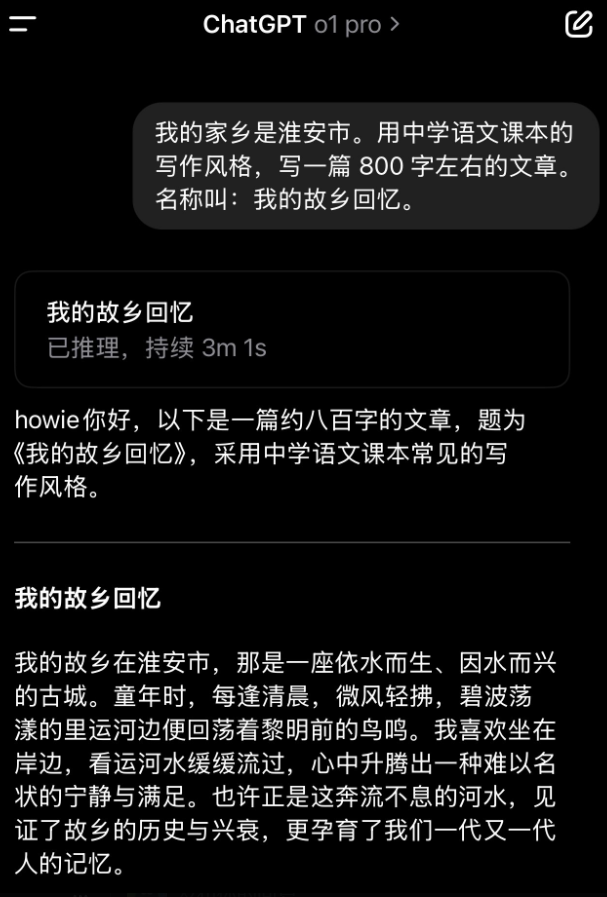

grok3 vs openai o1-pro:中文写作能力对比测试

左:gpt-o1-pro 右:grok3

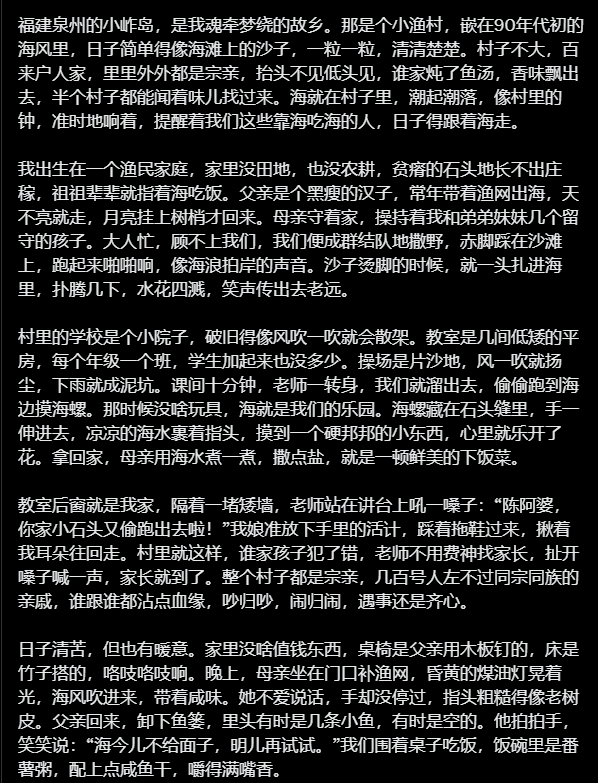

Grok 的 DeepSearch

让它找 deepseek 发布所有论文概览,它就像人一样去 Github 上面一个个网页打开,找了所有相关的论文,而不像 perplexity 只靠搜索网页内容

曹老师让写的诗歌

问题:参照黎巴嫩诗人纪伯伦的风格,结合现在人对于爱情的渴望和矛盾写一首诗

思考过程:

首先,我需要了解纪伯伦的风格。纪伯伦的诗歌常以深邃的哲理、象征意象和对人性矛盾的洞察为特点,语言优美而富有灵性。他的作品如《先知》探索了爱、自由、信仰等主题,常以对话或寓言形式呈现。

接下来,我要思考现代人对爱情的渴望和矛盾。现代人既渴望爱情的温暖与连接,又担心失去独立性、被伤害或陷入不真实的幻想。社交媒体和虚拟世界的影响加剧了这种矛盾:人们在屏幕前寻求爱,却害怕真实的亲密。

我的诗将模仿纪伯伦的象征手法,用自然意象(如飞鸟、河流、火焰)来表达爱情的双重性。诗中会融入现代元素(如手机、虚拟回音),以反映当代的爱情困境。

诗的结构将采用纪伯伦式的对话或自问自答,展现内心挣扎。语言力求简洁而富有哲理,邀请读者在爱情的悖论中沉思。

最后,我会以一个开放的结尾,留下思考的空间,就像纪伯伦常做的那样。

最终输出:

爱之双翼

在你心的荒野,我听见风的低语,

它说:爱是一只飞鸟,

翱翔于晨曦,却畏惧夜的深渊。

你渴求它的羽翼,

那柔软的触碰,点燃你沉睡的灵魂;

你又惧怕它的爪,

因它刺破你精心织就的梦。

爱是河流,

你跳入它的怀抱,求一滴永恒的水,

却在激流中迷失,

问自己:我是泳者,还是溺者?

它是你手中的火焰,

温暖你冰冷的指尖,

却也灼伤你紧握的信念。

你说:“我要你,

但不要你的影子跟随我太近。”

哦,现代的旅人,

你用手机的光芒寻找它的面容,

在屏幕的碎片里拼凑誓言;

却在深夜的寂静中,

祈求一双手,

比虚拟的回音更真实。

爱是两棵树,

根在地下纠缠,

枝却向天各奔自由。

你问它:“为何你如此辽阔,

却让我如此渺小?”

它答:“因我既是你的镜子,

也是你的远方。

拥抱我吧,

但别试图将我锁在你的时钟里。”

这首诗以纪伯伦式的象征手法,用飞鸟、河流、火焰和树等意象,呈现爱情既温暖又危险、既亲近又疏离的本质。加入“手机光芒”和“虚拟回音”等现代元素,呼应了当今人在数字时代对爱情的复杂情感:既渴望连接,又害怕真实靠近。结尾以对话形式留下开放的思考空间,邀请读者在爱情的悖论中自省。

注:另外马斯克发推说Grok 3 宣布对所有用户免费。直到对他们的服务崩溃!(普通人有问题个数限制)

Figure 发布 Helix 机器人视觉语言行动模型

-

历史上第一个类人机器人上身的高速连续控制模型

-

可以两台机器人用一个模型控制协作完成任务

-

可以捡起任何东西,不管他是否原来就认识

-

历史上第一个在本地 GPU 运行的机器人模型

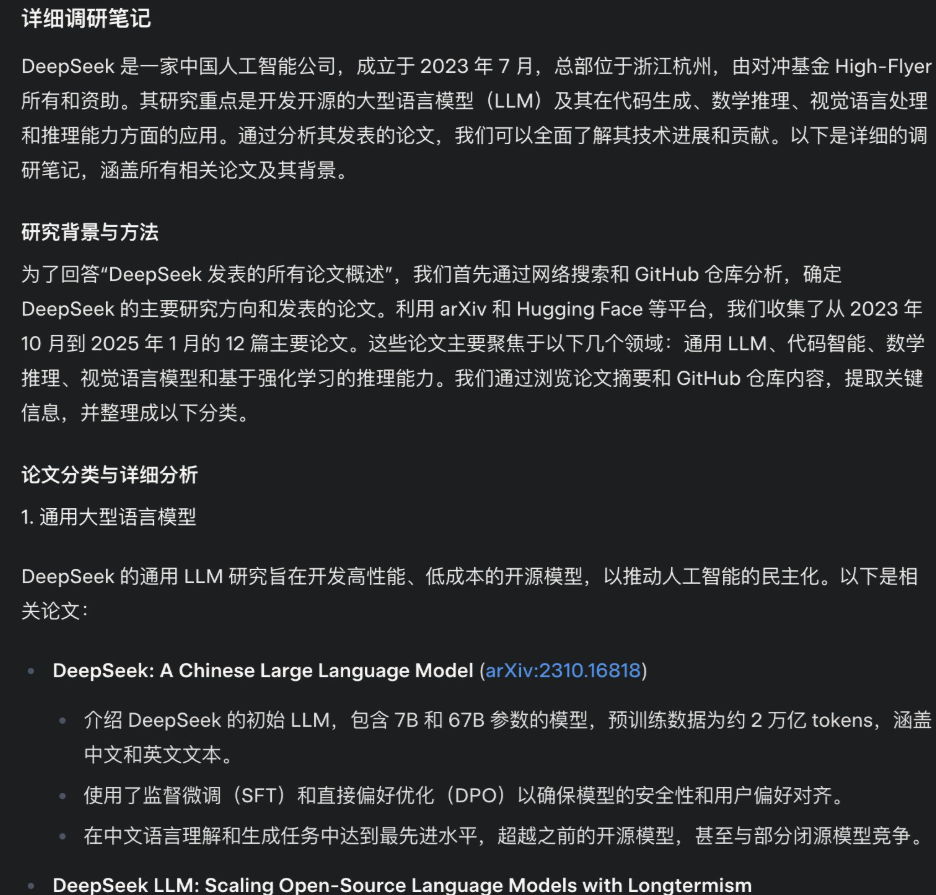

个人本地笔记 AI 知识库软件

本来是AI写代码的软件,结果用来写笔记也是不错的选择,并且还挺高效的。

- 帮助你用模糊的问题检索你的笔记库

- 帮助你基于笔记库进行研究

- 帮你生成和修改笔记

OpenAI的SWE-Lancer论文

这篇论文在尝试引入一个新的衡量标准去评估不同模型的编程能力,因为之前大量的LLM,比如OpenAI o1、o3,DeepSeek R1、Grok3等模型按Codeforces的评估标准,都是可以在国际编程竞赛拿金牌的水平,远超人类平均水平了。

但是在现实的软件工程中却不是那么回事。真正用过Cursor AI编程的人都会能感觉到Claude 3.5 Sonnet才是最能打,写实际的软件代码最好的模型。而且虽然模型能力算是跨过了某个让普通人能够开始编程做小产品的临界点了,但你在用的过程中还是会发生不少问题,有一些学习的障碍和门槛还是需要你跨过。

写代码5分钟,改bug两小时也是AI编程的常态了。

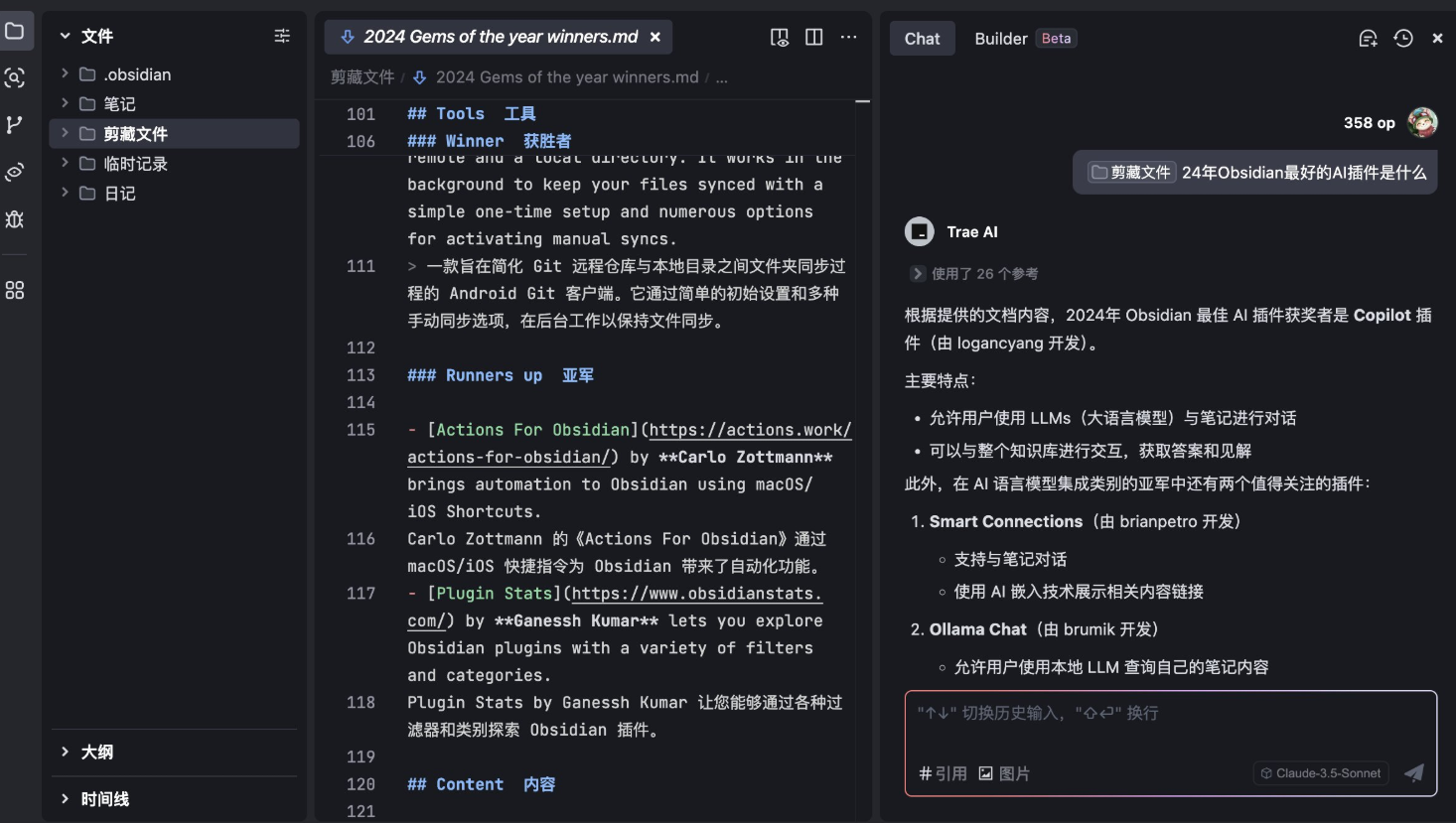

这次OpenAI为LLMs的编程能力引入了一个新的软件工程的评估标准——SWE-Lancer。

这个评估集是他们从自由职业者的接单平台Upwork上选出来的。总共包括1488个价值100万美元的任务。 这些任务分为独立开发者任务(IC SWE)和技术管理任务(SWE Manager)。

前者是去做代码修复与功能实现,后者是对于不同的任务进行方案决策。从开发类型来说有分为客户端应用(前端)逻辑、用户界面/用户体验、服务端逻辑三类。

OpenAI这次评估是选择了GPT-4o、o1、Claude 3.5 Sonnet三个模型做测试对比,得到的结论还挺有趣的,而且可能有些反常识:

1、Claude 3.5 Sonnet依然是最佳的现实世界软件工程的编程模型选择,能完成大约40%的任务;

2、大模型在技术管理任务(SWE Manager)的成功率明显优于独立开发者任务(IC SWE),所以这是说技术管理者更容易被AI替代?

3、AI在服务端逻辑类任务上的成功率优于前端任何和UI/UX任务(尽管一般人现在会判断AI编程更适合用来写前端代码)。

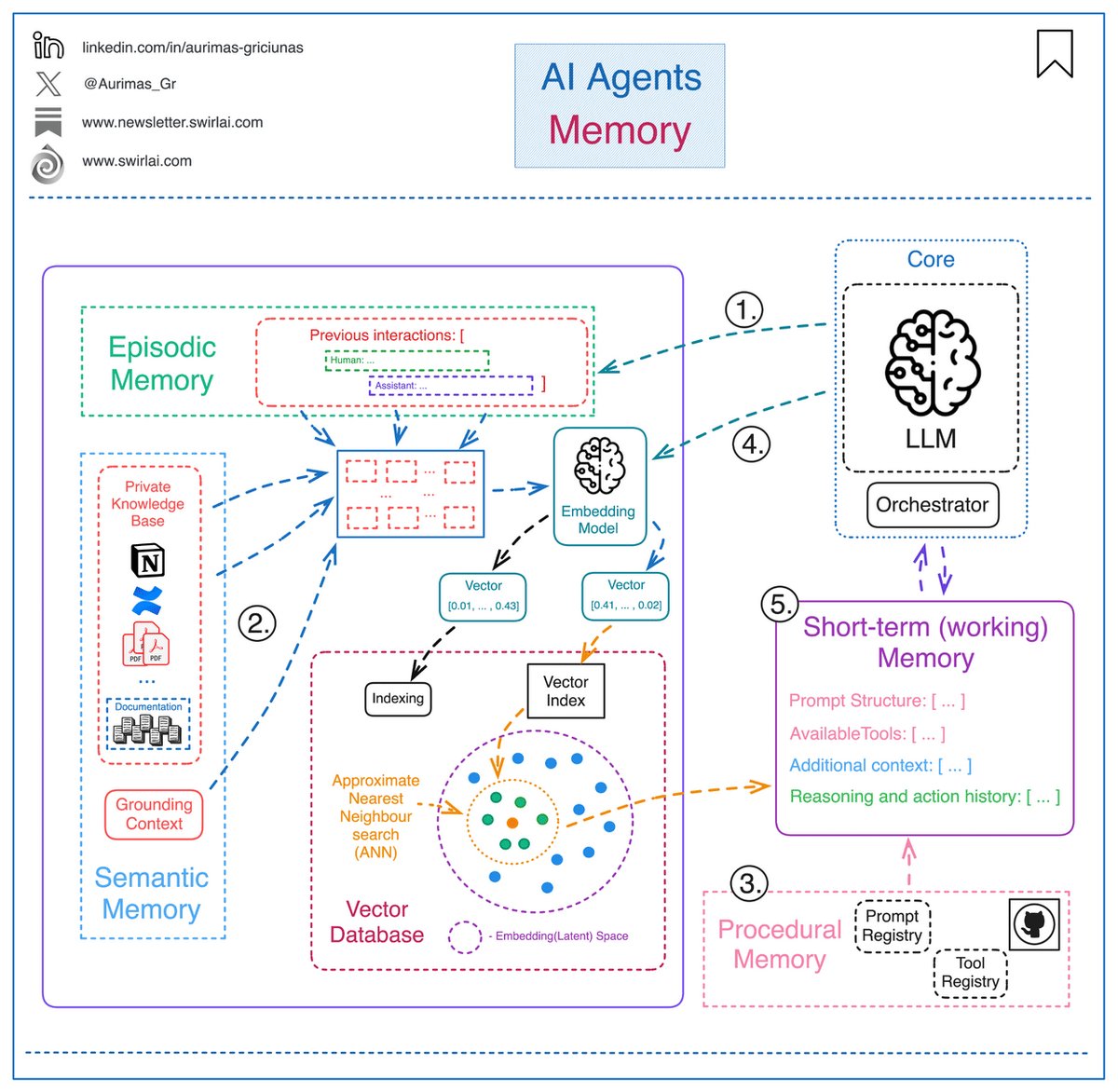

AI 智能体的记忆

简单来说,AI 智能体的记忆就是我们通过提示词提供给大语言模型(LLM)的上下文信息。

这些信息能帮助智能体在没有过去的互动记录或数据的情况下,更好地规划和应对情况。 智能体的记忆可以分成以下四种类型:

- 情景记忆 (Episodic) 这是智能体过去的互动和行动记录。每次智能体完成一个动作,控制它的应用程序就会把这个动作保存在某个地方(比如一个持久性存储),以便以后需要时可以调出来用。举个例子,可以用向量数据库来保存这些互动的语义信息,方便查找和使用。

- 语义记忆 (Semantic) 这是智能体能获取的外部信息,以及它对自己应该知道的事情的了解。你可以把这想象成一个“知识库”,有点像 RAG(检索增强生成)技术里用的上下文。这个知识库可能是智能体专有的内部信息,也可能是从海量互联网数据中提取出来的部分内容,用来让回答更精准。

- 程序记忆 这是关于系统本身的信息,比如系统提示的结构、能用的工具、防护措施等等。这些信息通常会存在 Git、提示词库和工具注册表里,相当于智能体的“操作手册”。

- 短期记忆的来源 有时候,智能体的应用程序会从长期记忆中调取信息,并在需要时临时保存在本地。

- 短期记忆(或工作记忆) 所有从长期记忆中调取的、或者临时存在本地的数据,都被称为短期记忆或工作记忆。把这些信息整合成一个提示词,交给大语言模型,它就会根据这些内容给出下一步的行动建议。

通常,我们把情景记忆(Episodic)、语义记忆(Semantic)和程序记忆(Procedural)称为长期记忆,而短期记忆就是第 5 点提到的内容(Working Memory)。

一个可能的实现细节图示 (想象一下:长期记忆像一个大仓库,短期记忆是从仓库里拿出来正在用的东西,提示词就是把这些东西打包交给大模型的过程。)

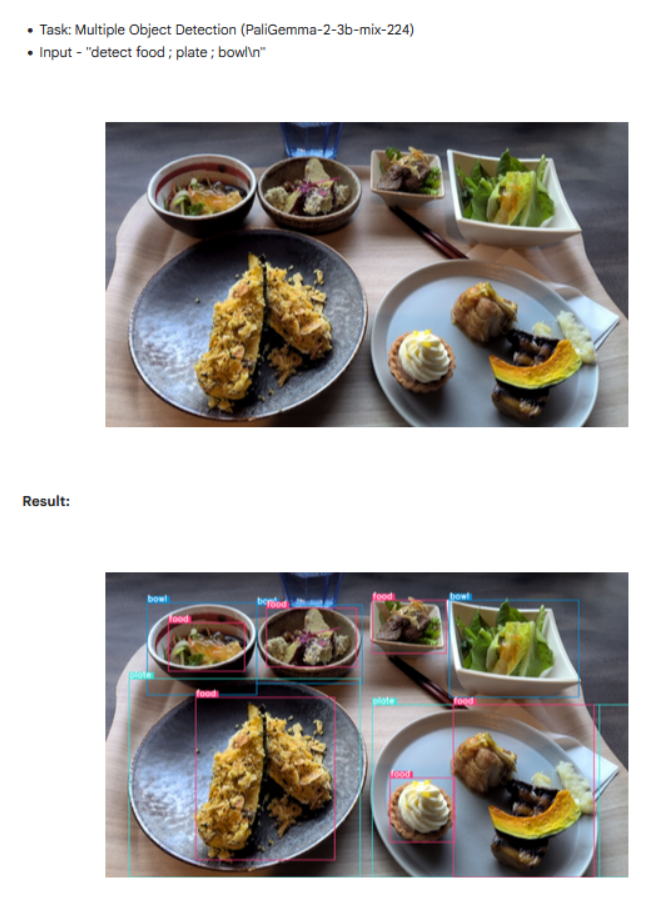

谷歌开源 一个很强的多模态模型:PaliGemma 2 mix

支持图像字幕、OCR、图像问答、对象检测和分割。参数大小从 3B 到 28B,每个人都能找到适合自己的模型。

Pika AI 刚刚发布了 Pikaswap

你可以将现实世界视频中的物体与任何东西交换

Qwen2.5-VL 已经发布了,目前官方放出来3个大小的模型

Qwen2.5-VL 的主要特点如下所示:

- 感知更丰富的世界:Qwen2.5-VL 不仅擅长识别常见物体,如花、鸟、鱼和昆虫,还能够分析图像中的文本、图表、图标、图形和布局。

- Agent:Qwen2.5-VL 直接作为一个视觉 Agent,可以推理并动态地使用工具,初步具备了使用电脑和使用手机的能力。

- 理解长视频和捕捉事件:Qwen2.5-VL 能够理解超过 1 小时的视频,并且这次它具备了通过精准定位相关视频片段来捕捉事件的新能力。

- 视觉定位:Qwen2.5-VL 可以通过生成 bounding boxes 或者 points 来准确定位图像中的物体,并能够为坐标和属性提供稳定的 JSON 输出。

- 结构化输出:对于发票、表单、表格等数据,Qwen2.5-VL 支持其内容的结构化输出,惠及金融、商业等领域的应用。

模型能力案例

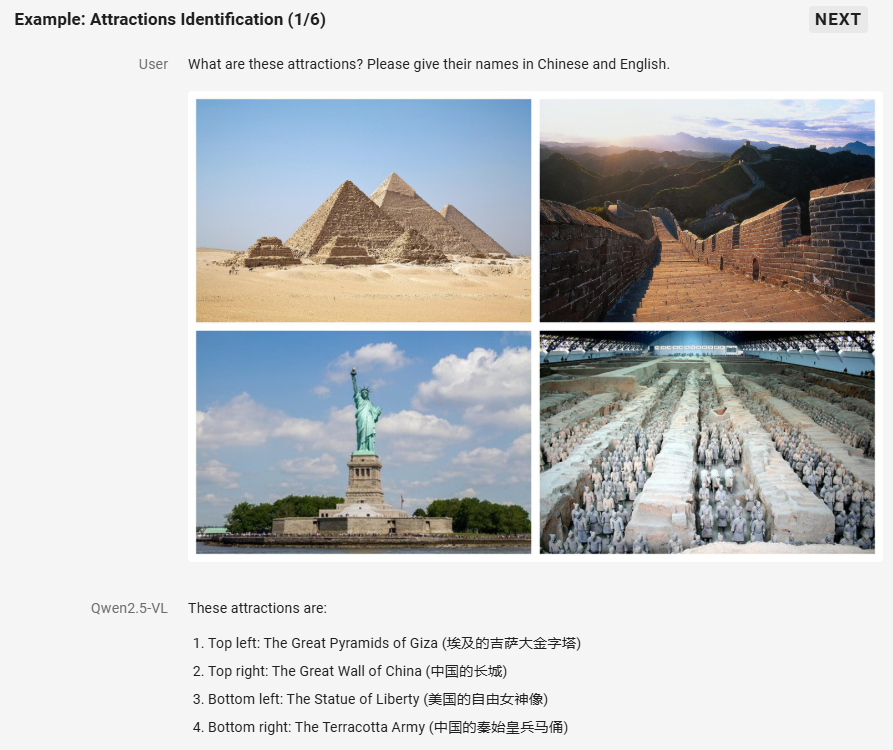

万物识别

Qwen2.5-VL 显著增强了其通用图像识别能力,大幅扩大了可识别的图像类别量级。不仅包括植物、动物、著名山川的地标,还包括影视作品中的 IP,以及各种各样的商品。

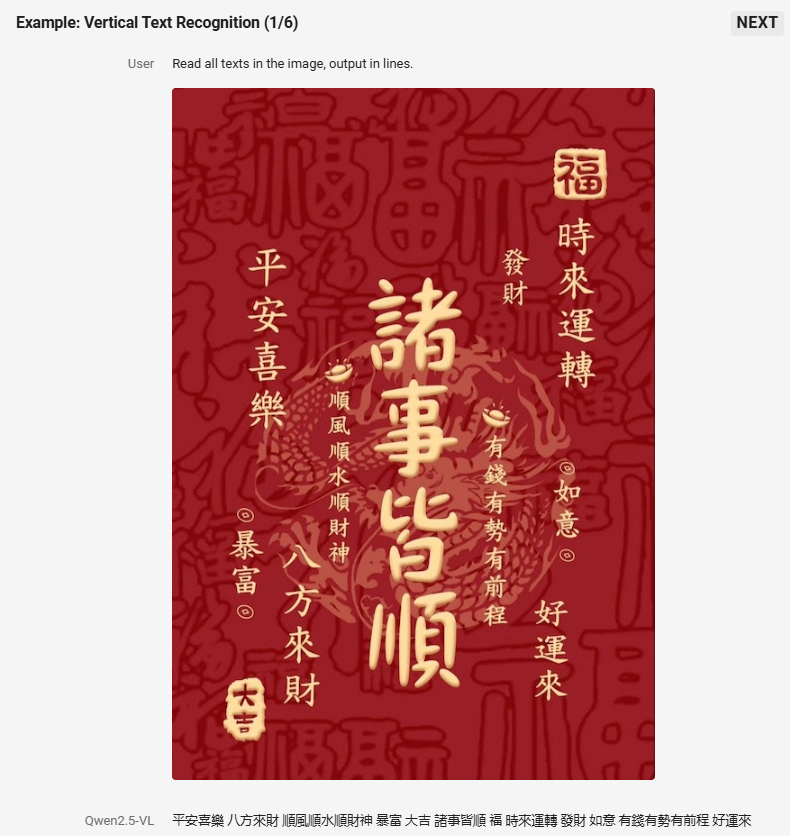

全面的文字识别和理解

Qwen2.5-VL 将 OCR 识别能力提升至一个新的水平,增强了多场景、多语言和多方向的文本识别和文本定位能力。同时,在信息抽取能力上进行大幅度增强,以满足日益增长的资质审核、金融商务等数字化、智能化需求。

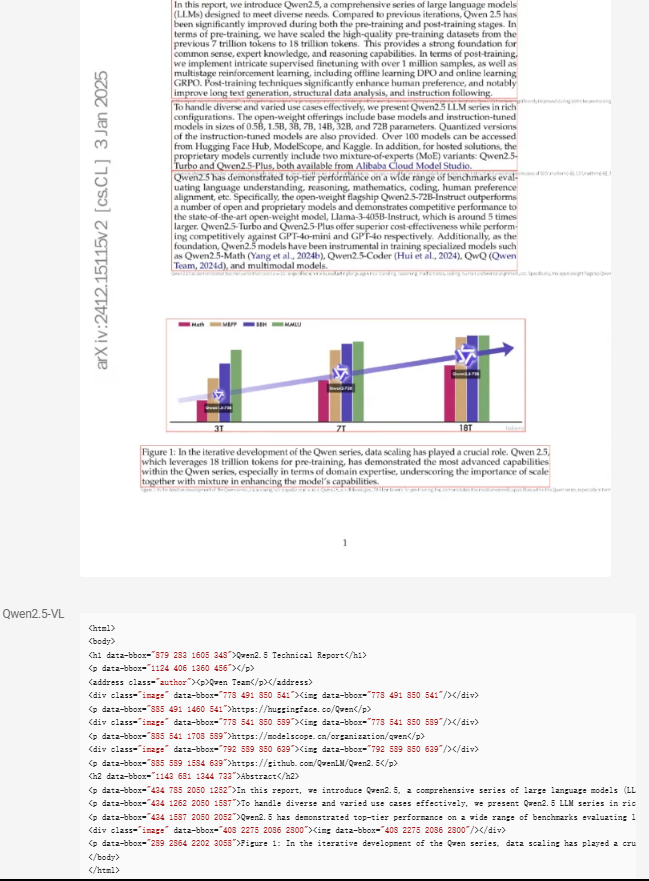

文档解析

在 Qwen2.5-VL 中,我们在设计了一种更全面的文档解析格式,称为 QwenVL HTML 格式,它既可以将文档中的文本精准地识别出来,也能够提取文档元素(如图片、表格等)的位置信息,从而准确地将文档中的版面布局进行精准还原。基于精心构建的海量数据,QwenVL HTML 可以对广泛的场景进行鲁棒的文档解析,比如杂志、论文、网页、甚至手机截屏等等。

等等功能,详情见:https://qwenlm.github.io/zh/blog/qwen2.5-vl/